Apple不装了:AI iPhone将至!

撰稿 | 云昭

出品 | 51CTO技术栈(微信号:blog51cto)

临近年末,生成式AI的“惊艳”速度远远超过了人们“野望”它的速度。比如炙手可热的Midjourney推出了再度炸街的V6版本,再比如谣传月底即将发布的GPT4.5、谷歌的多模态模型Gemini发布等等。

然而,Apple看似在这一年里显得格外低调,没有像谷歌那样硬刚OpenAI的GPT4,也没有像微软或亚马逊那样高调的将大模型搞进“云”。

但今天大家才明白,Apple搞的事情,却是决定成败的“最后一公里”的事情:让大模型高效地跑在iPhone的内存上!

1、大模型,在闪存中

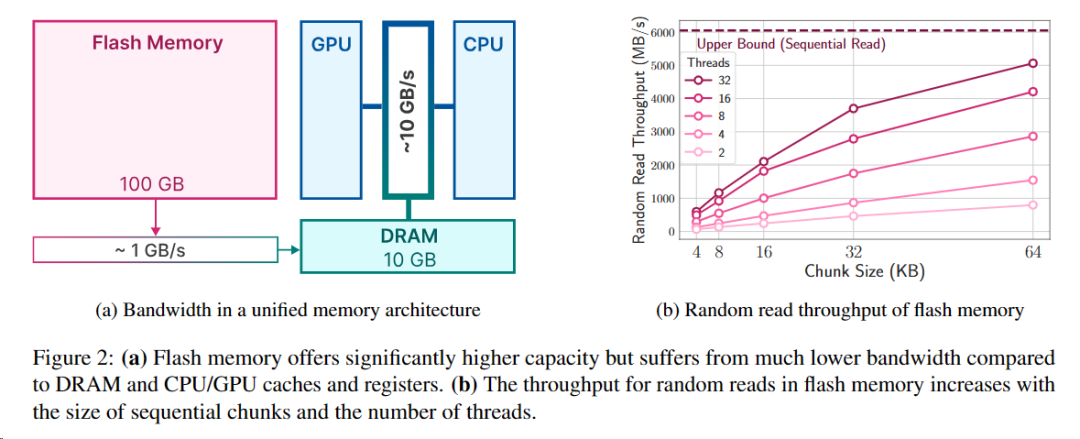

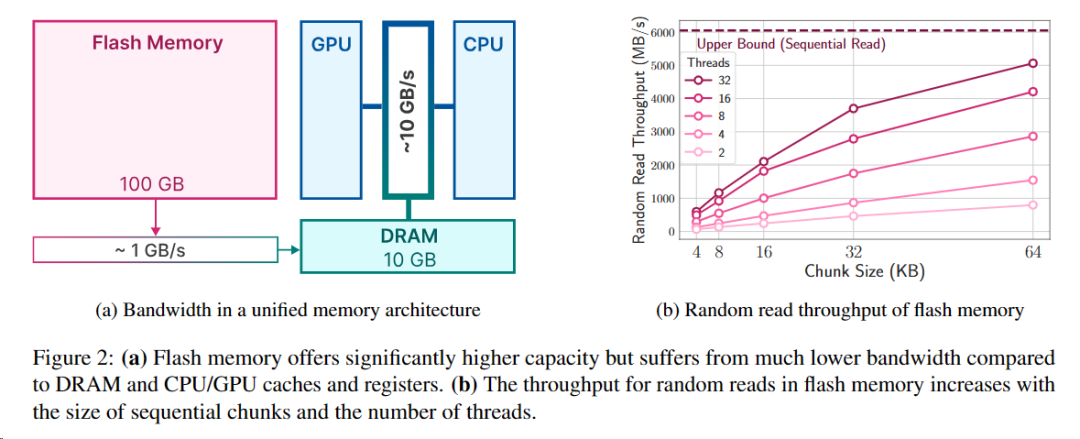

Apple亮出剑锋,在20日发表了一篇很硬核的在手机内存上运行大模型的论文(《LLM在闪存中:内存有限的高效大型语言模型推理》),在文中构建了一个可以大大扩展LLM适用性和普及性的研究框架,该框架以闪存为基础进行推理,并在两个关键领域进行了优化:减少闪存传输的数据量,读取更大、更连续的数据块。

图片

图片

那么,Apple是如何做到的呢?它采用了两种主要技术:

首先,“窗口化”通过重复使用先前激活的神经元来战略性地减少数据传输。

其次,根据闪存的时序数据的访问强度量身定制“行-列绑定”技术,从而增加了从闪存读取的数据块的大小。

图片

图片

看不懂不重要,重要的是极大扩大了在手机上运行大模型的参数大小,以及加快了模型的推理速度,具体而言:

这两种方法共同实现了运行高达可用DRAM两倍大小的模型,与CPU和GPU中的原始加载方法相比,推理速度分别提高了4-5倍和20-25倍。

这也就意味着,将大模型搬到手机中,基本上算是板上钉钉的事情了!Apple正在积攒新的AI黑科技,从芯片、到存储、再到模型和应用,Apple一改缓慢姿态,杀招即将亮出!且让我们看看Apple的近期动作。

2、 Apple的自研大模型怎么样了

GPT4的发布,让整个科技行业从兴奋到狂热,只有Apple这家科技巨头貌似“心静如水”。

然而,即使Apple首席执行官库克一度公开表示:对于苹果公司多年来一直致力于生成式AI,但稀少的成果报道无疑加重了苹果内部人员在猝不及防之间,对于技术重大延迟的焦虑感。

此前就有消息报道,7月,苹果发布了自己的大型语言模型Ajax(基于谷歌的JAX),并引入了一个名为“Apple GPT”的内部聊天机器人进行测试。目前,该聊天机器人程序主要用于产品的原型设计,只有少数有权限的人才能访问。

然而,这项技术是否能与现有产品竞争,以及苹果如何将其有效地集成到其产品中,依旧有待评估。

3、Apple在开局落后的原因

首先是投入成本高昂。据MacRumors称,苹果在对话式人工智能研究上的花费,高达每天数百万美元,因为训练语言模型需要大量硬件投入。

此外,出于对消费者隐私和AI偏见的问题,苹果正在思考如何在尊重客户隐私承诺的前提下使用和处理个人数据。

当然,不得不提的是由于担心内部数据泄露的问题,前期该公司也限制了员工对于AI工具的使用。

不过好在,Apple也不是没有积累,据供应链数据显示,Apple可能会在2023年建造数百个人工智能服务器,而明年的建设数量将会更多。

4、加速的Apple,虎狼之师

不过,既然“大模型+应用”的打法一时陷入困局,“设备+大模型”更像是苹果的不二选择。

在繁荣时期的相对被动并不影响苹果凭借自身强大壁垒的厚积薄发,大概在10月左右,苹果似乎开始改变了其在生成式AI时代下的新打法:

在其所有设备上开发生成式AI功能,包括iOS、Siri和其他应用程序。

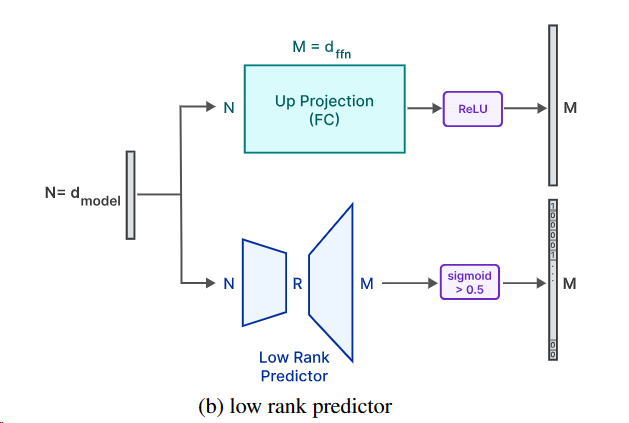

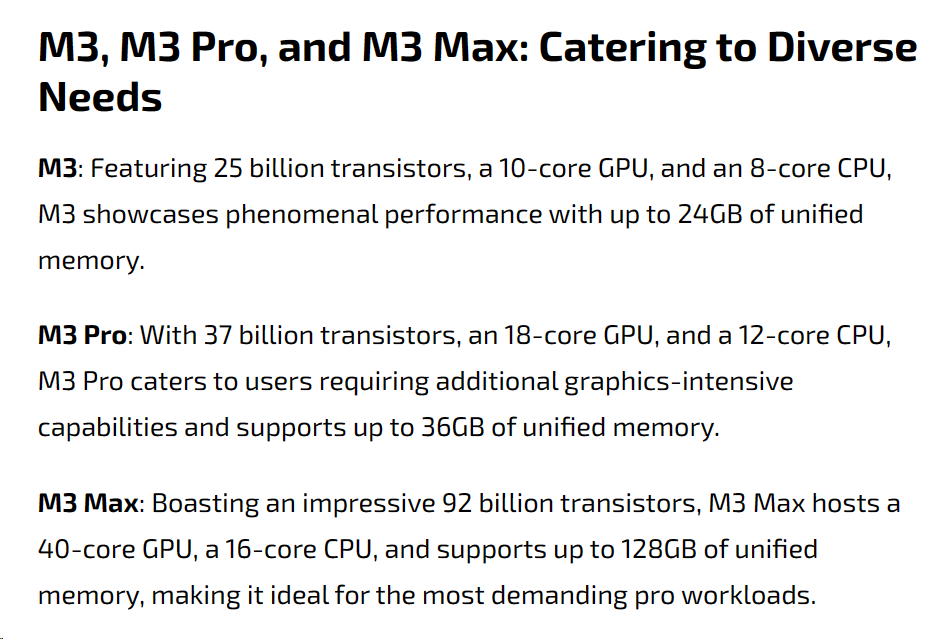

最先曝出惊喜的是,11月,开发人员在搭载M3系列的芯片的14英寸MacBook Pro上无缝地运行最大的开源GPT模型(具有1800亿个参数的Falcon),而且质量损失很低。同时还声称,其增强的神经引擎有助于加速强大的机器学习(ML)模型,同时保护隐私。

这让AI开发者们自然合不拢嘴。此外,苹果公司在其博客文章中表示:“该版本的MacBook支持高达128GB的内存,可以解锁以前在笔记本电脑上无法实现的工作流程。”

图片

图片

Apple的“生成式人工智能计划”由高级副总裁John Giannandrea和Craig Federighi领导。苹果公司服务主管Eddy Cue也参与其中,三人计划每年为此投资约10亿美元。

Giannandrea的团队负责开发新人工智能系统的底层技术,同时还正在对Siri进行重大改革,致力于使其更加智能,最早可能在明年发布改进版。

但值得一提的是,由于Siri的构建的“繁琐设计”,苹果可能需要相当长的时间来更新数据库以支持新功能。一位前工程师表示,每次添加新短语需要重建Siri数据库,可能需要长达六周的时间,而添加搜索工具等更复杂的功能可能需要一年以上的时间。

Federighi的软件工程团队正在将人工智能融入下一版本的iOS18,重点是使用大型语言模型来增强Siri和消息应用程序的功能。

苹果的软件工程团队正在探索将生成性人工智能集成到Xcode等开发工具中,这可以帮助应用程序开发人员更高效地编写应用程序。

此外,Cue的团队正在努力为尽可能多的苹果应用程序添加人工智能功能,包括Apple Music、Pages、Keynote和Xcode等生产力应用程序。

如果计划顺利,上述所有这些Apple的人工智能,可能会在2024年底前完成。

5、Apple:GenAI的部署之争

围绕生成式AI能力部署的追赶,似乎有三条路径:基于设备,基于云端,还是混合?

苹果内部正在进行的一场辩论,基于设备上的部署,会更加优先考虑速度和隐私,而基于云的方法,则将实现更上层、更高级的操作。在这些部署方法之间的选择至关重要,因为苹果的目标是在快速发展的生成人工智能领域保持竞争力。

不过目前看来,苹果选择了混合选项。

6、 2024,边缘AI之战

一时间,智能手机端搭配AI有望成为新卖点。而端侧部署生成式AI能力,或者说边缘AI的好处不言而喻——

个人信息无需上传云端,隐私泄露和数据安全风险降低;AI模型接入本地数据库和个人信息,有望实现更加个性化定制小模型,提供更个性的用户服务;通过软硬件适配,边缘AI降低运行成本、加快响应速度和提高服务效率。

因此,除了苹果,着急在生成式AI发力的手机厂商同样不少。

刚过去的11月,三星推出了自己的设备大模型“Gauss”。据报道,Gauss将被纳入即将推出的Galaxy S24智能手机中,该手机定于2024年初发布。

该公司打算将这种语言模型集成到手机、笔记本电脑和平板电脑等设备中,以增强其智能设备的功能。

此外,谷歌还宣布了其名为Gemini Nano的设备LLM,将在即将推出的谷歌Pixel 8手机中推出,提供录音机应用程序中的汇总和Gboard中的智能回复等功能。

视线拉回国内,8月小米首次在手机上跑通了13亿参数的大模型;10月荣耀CEO赵明表官宣新机将会搭载全新骁龙8Gen3以及荣耀自研的7B端侧AI大模型;11月,vivo 发布搭载了蓝心大模型的x100系列手机,落地终端侧70亿参数大语言模型,跑通端侧130亿参数模型,并称这是全球首个百亿大模型在终端调通的大模型手机。

根据市场调查机构Counterpoint Research近日发布的《生成式AI智能手机出货量洞察》报告,预估2024年会成为生成式AI智能手机的关键元年,预估出货量将达到1亿台,到2027年将达到5.22亿台。

7、写在最后:让手机厂商卷起来吧

可以说,端侧大模型,或者说边缘AI的号角,已经在年末吹响了。

Robin那句“卷大模型没意义”非常nice。有足够应用市场的技术产品才能推动整个社会的进步。与其说大模型需要变小,不如说大模型需要一种与之相匹配的硬核载体。

目前看,端侧/边缘AI,似乎成为了移动互联网时代的拐点之战。大家一起期待AI手机的到来吧!

参考链接:

https://analyticsindiamag.com/samsung-announces-gauss-on-device-generative-ai/

https://analyticsindiamag.com/apple-optimises-llms-for-edge-use-cases/