铁了心要打败OpenAI!坚信开源打败闭源!这家知名数据厂商4个月打造最强开源大模型!性能超越Claude3,速度是羊驼2倍

撰稿 | 言征

出品 | 51CTO技术栈(微信号:blog51cto)

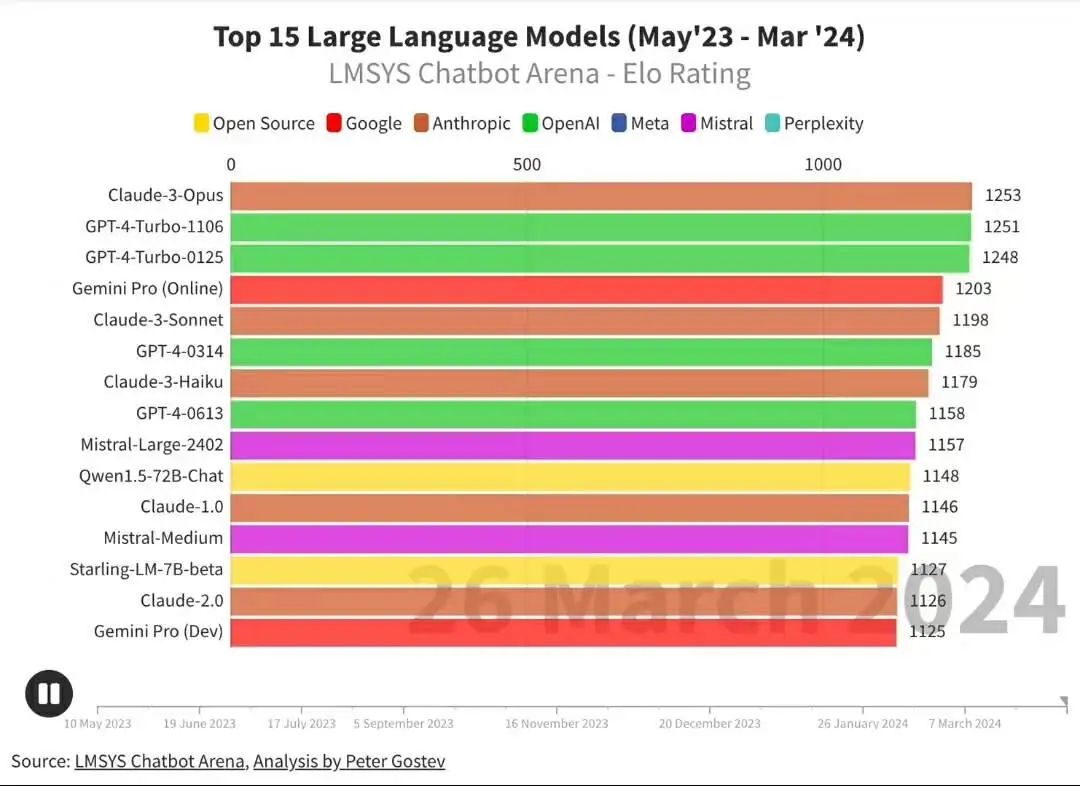

大模型领域,迭代的速度简直要以天计算。昨天,大家还在热议Claude3超大杯版Opus在Elo Rating榜单上取代GPT4-Turbo-1106成为了新王。今天大家又发现开源大模型的王者又换主了!

图片

图片

3月27日,全球知名的数据仓库服务提供商Databricks发布了一系列开源的大型语言模型DBRX,称其在标准基准测试中的表现优于OpenAI的GPT3.5模型和开源模型,如Mixtral、Claude 3、Llama 2和Grok-1。同时,模型的训练和推理优势也非常明显,成本降低明显。

一、独占鳌头!优于SOTA!

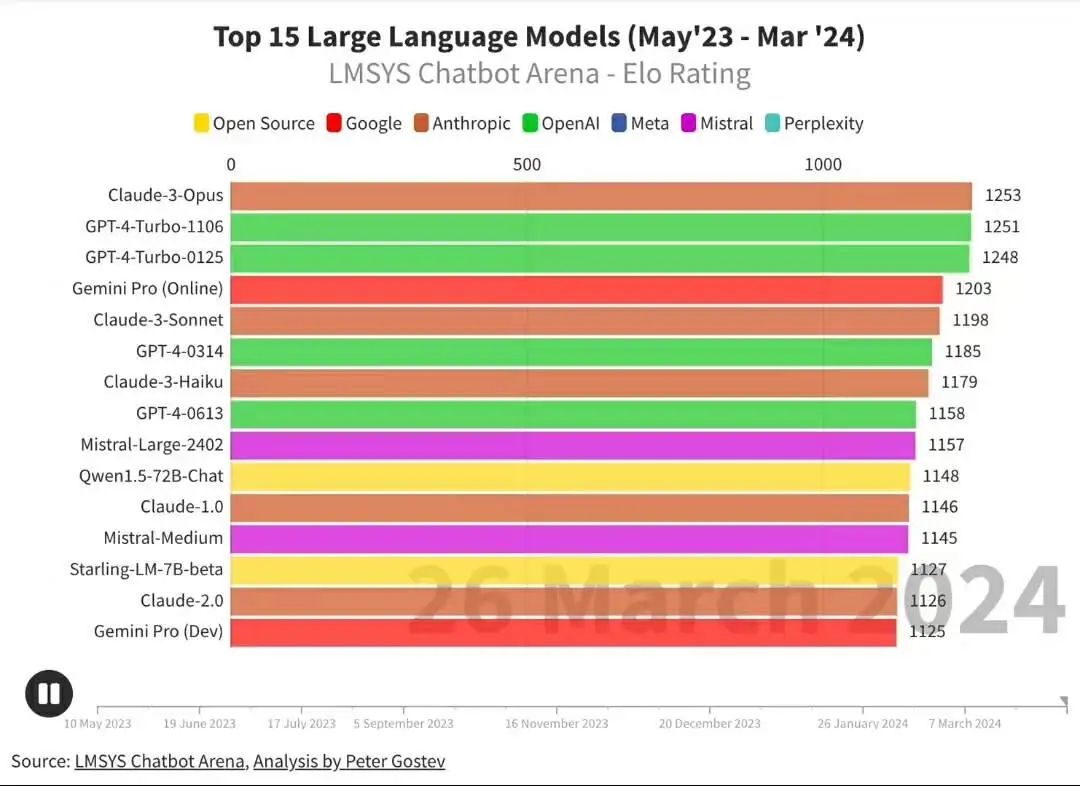

副总裁兼 MosaicML 的创始人Naveen Rao心情非常激动,“Databricks 今天宣布推出世界上最强大的开源模型DBRX。这款新模型在各种基准测试中均优于其他 SOTA 开源模型,如 Llama 2 70B、Mixtral-8x7B 和 Grok-1,包括语言理解(MMLU)、编程(Human Eval)和数学(GSM 8K)。”

可喜的是,DBRX 还超越了 OpenAI 的 GPT-3.5,并在类似基准测试中与 GPT-4 的差距逐渐缩小,这不可避免地减少了对专有闭源模型的依赖,转而采用开源模型,并显著降低了成本。

图片

图片

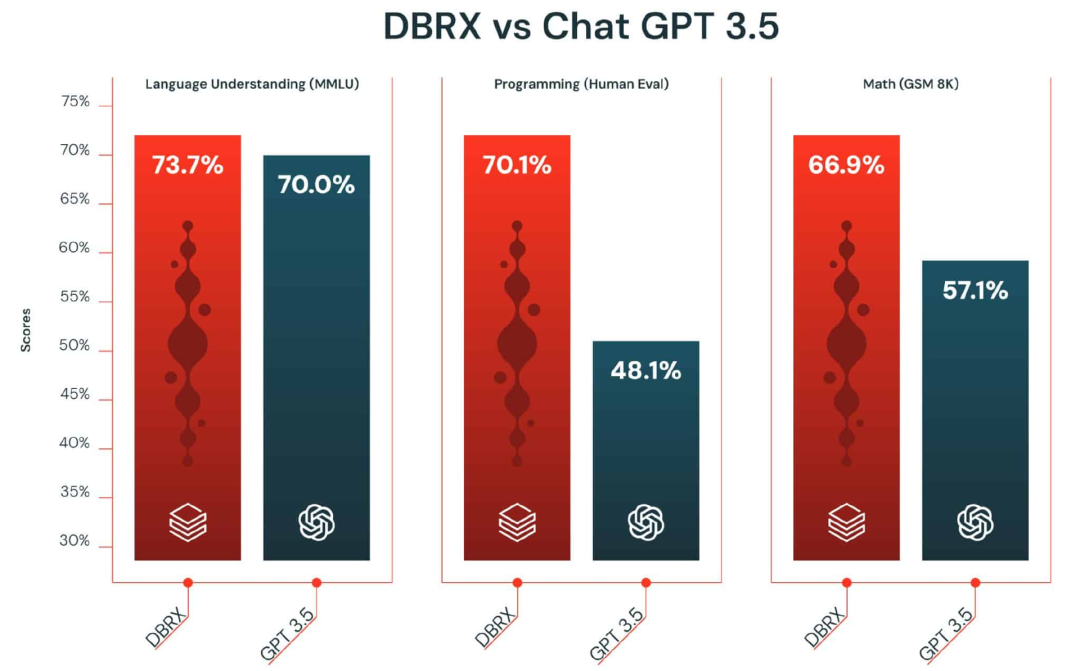

在一系列标准基准中,DBRX可谓绝大多数都独占鳌头。根据测评结果显示,它超过了GPT-3.5,与Gemini 1.0 Pro具有竞争力。

图片

图片

此外,它在生成代码方面非常突出,超越了CodeLLaMA-70B等专业模型,此外它还具有通用LLM的优势。

结构上看,DBRX采用了更细粒度的专家混合(MoE)架构,性能和训练效率得到了显著的提升,落实到使用体验上,就是输出得更快!

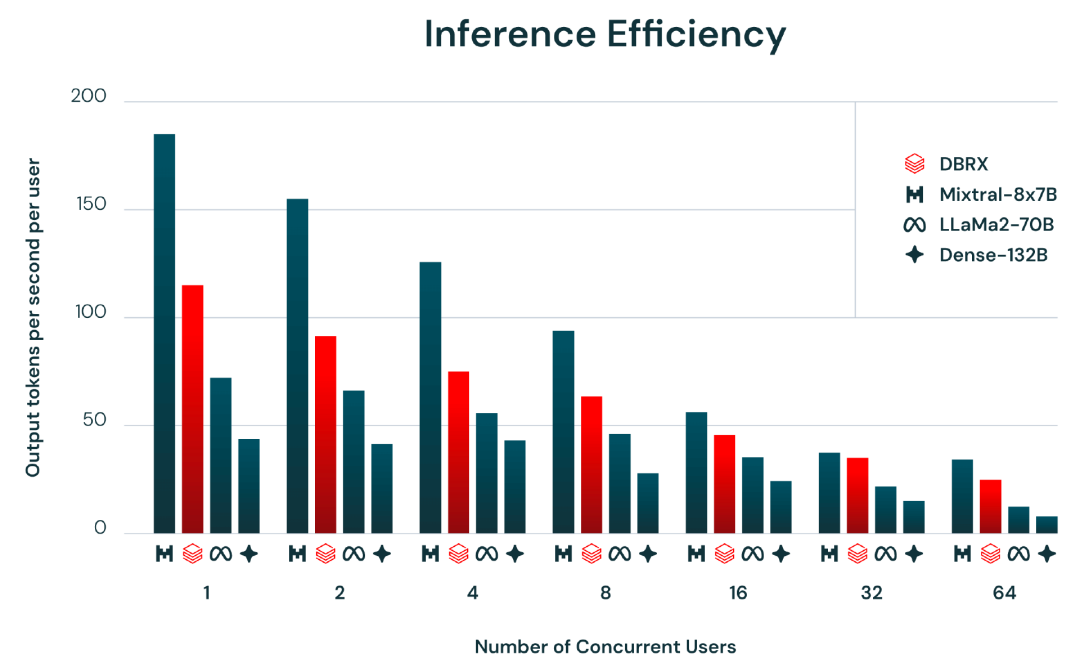

据悉,其推理速度比LLaMA2-70B快2倍,对比来看,DBRX输出“每秒100个tokens,而Llama输出的是每秒35个tokens”;就总参数计数和激活参数量而言,DBRX约为Grok-1大小的40%。当托管在Mosaic AI Model Serving上时,DBRX可以以高达150 tok/s/用户的速度生成文本。

图片

图片

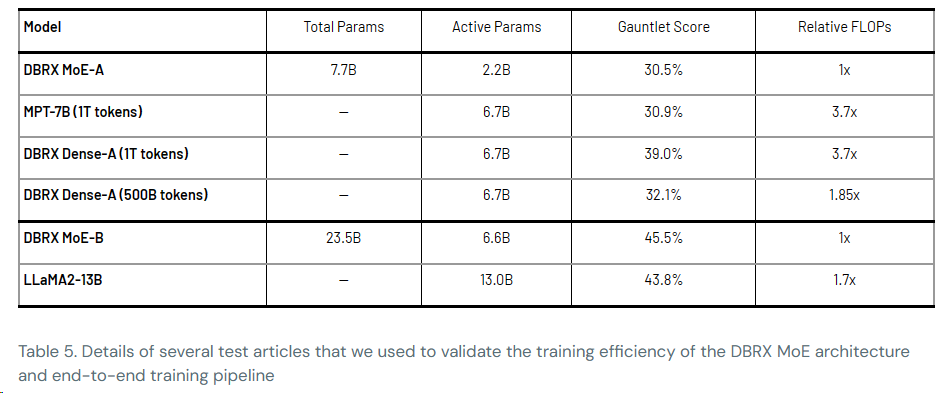

“我们的客户会发现,在相同的最终模型质量下,训练MoE的FLOP效率也比训练密集模型高出约2倍。端到端,我们的DBRX总体方案(包括预训练数据、模型架构和优化策略)可以与我们上一代MPT模型的质量相匹配,计算量减少近4倍。”

二、性能更强!DBRX怎么做到的?

1.架构更精细

DBRX是一个基于Transformer的解码器的大型语言模型(LLM),使用下一个令牌预测进行训练。它使用了一种细粒度的专家混合(MoE)架构,共有132B个参数,其中36B个参数在任何输入上都是active的。它是在文本和代码数据的12T标记上进行预训练的。与Mixtral和Grok-1等其他开放MoE模型相比,DBRX是细粒度的,这意味着它使用了大量较小的专家。

DBRX有16名专家,选择4名,而Mixtral和Grok-1有8名专家,并选择2名。这提供了65倍以上可能的专家组合,我们发现这提高了模型质量。DBRX使用旋转位置编码(RoPE)、门控线性单元(GLU)和分组查询注意力(GQA)。它使用tiktoken存储库中提供的GPT-4 令牌化器(tokenizer) 。

这些都是团队通过详尽的评估和缩放实验做出的选择。

同时,得益于模型采用了 MoE 架构,该架构提供了显著的经济效益。“在服务方面,经济效益要好得多。在浮点运算和浮点操作方面,它们的性能提高了两倍以上,”Rao 分享道。

2.全新的数据集合,训练工具和训练细节

DBRX 是在由 3.2Tbps Infiniband 连接的 3072 个 NVIDIA H100 上进行训练的。构建 DBRX 的主要过程——包括预训练、后训练、评估、红队测试和调优——持续了三个月。

数据方面,为了构建 DBRX,团队利用了 Databricks 向客户提供的同一套工具,包括:使用 Unity Catalog 管理和治理训练数据;使用新收购的 Lilac AI 探索这些数据;使用 Apache Spark™ 和 Databricks 笔记本处理和清理这些数据;

值得一提的是,DBRX是在精心策划的数据的上预训练的,大小为12T tokens和32k tokens的最大上下文窗口长度。据估计,与用于预训练MPT系列模型的数据相比,该数据至少是 token-for-token的两倍。

预训练方面,该团队使用“课程学习”的方法进行预训练,在训练过程中改变数据组合,从而大大提高模型质量。

同时,他们使用优化过的开源训练库(MegaBlocks、LLM Foundry、Composer 和 Streaming)训练 DBRX。

而且,他们通过 Mosaic AI Training 服务在数千个 GPU 上进行大规模模型训练和微调。此外,还使用 MLflow 记录结果。

收集反馈数据方面,通过 Mosaic AI Model Serving 和 Inference Tables 收集人类反馈,以改进质量和安全性。借用Databricks Playground 工具可以手动对模型进行实验。

图片

图片

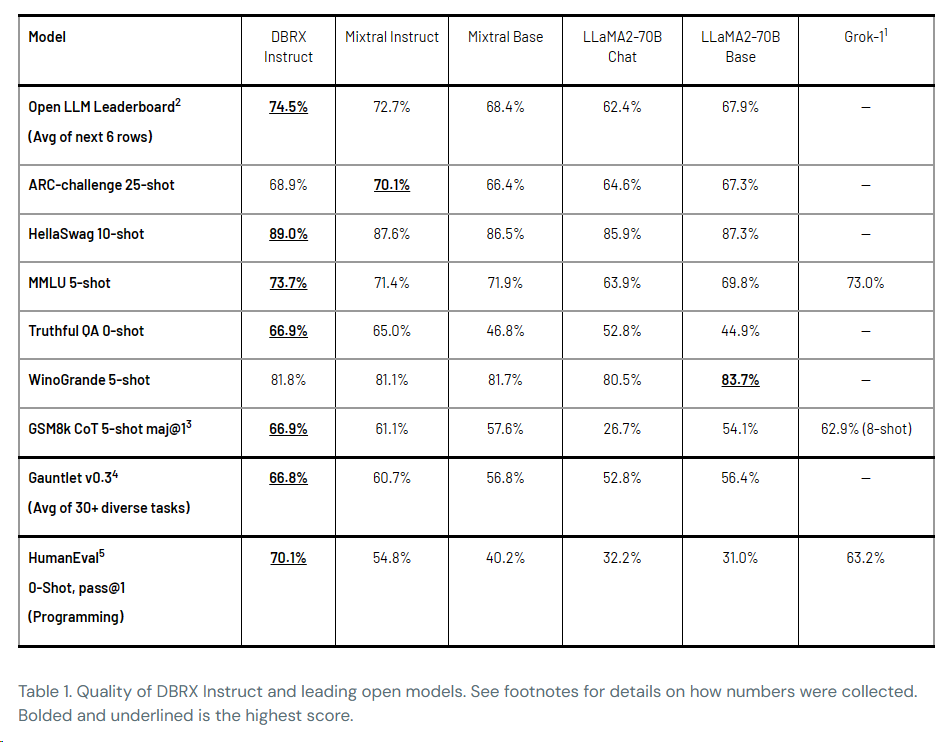

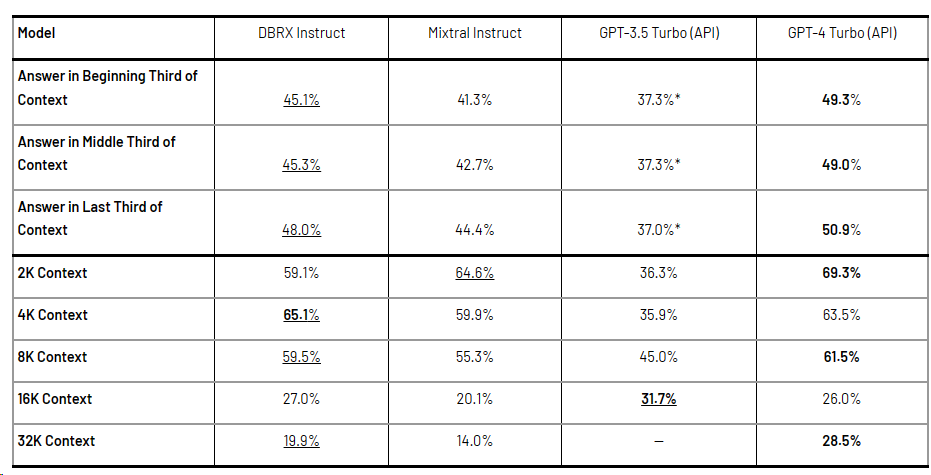

当然,并不是所有能力都能超过GPT-4,在长文本任务、RAG方面,DBRX还存在有一定差距。

在一系列长文本基准测试(包括来自《Lost in the Middle》论文的 KV-Pairs 和 HotpotQAXL,即 HotPotQA 的修改版本,该版本将任务扩展到更长的序列长度)上,DBRX的性能与 Mixtral Instruct 以及 GPT-3.5 Turbo 和 GPT-4 Turbo API 的最新版本的性能。GPT-4 Turbo 通常在这些任务中表现最佳。

图片

图片

不过值得注意的是,除了一个例外,DBRX Instruct 在所有序列长度的所有部分上的表现均优于 GPT-3.5 Turbo。DBRX Instruct 和 Mixtral Instruct 的整体性能相似。

三、铁了心要打败OpenAIDatabricks背水一战

Rao 表示,“没有差异化的用例,就无法击败 OpenAI……除非你能超越他们,否则试图在平等条件下竞争是徒劳的。如果不能提供独特的优势或更具成本效益的解决方案,那么采用他人的模型就没有意义。”

而Databriks差异化的底气在于:公司的技术整合和专有数据,这两项法宝会继续推动新的、更好的模型变体的诞生。

推出DBRX的战略可以追溯到去年4月,当时该公司推出了第一个开源LLM,即Dolly 2.0,作为服务于企业的GPT 3.5和GPT-4等型号的替代产品。

同时,Rao透露了下一步有关开源模型的计划:

(1)将发布RAG工具,“RAG对我们来说是一个巨大而重要的模式,我们将发布工具。”此外,Databricks中有非常简单的RAG方法,接下来的一个大动作是会让DBRX模型成为RAG的最佳生成器模型。

(2)DBRX模型将会托管在AWS、谷歌云(GCP)和Azure等所有主要云环境的产品中。作为一个开源模型,用户可以随心所欲地使用它。

(3)DBRX 预计也将通过 Nvidia API Catalog 提供,并在 Nvidia NIM 推理微服务上得到支持。

四、开源大模型商业模式找到了:挣构建、定制、服务工具的钱

现在DBRX的推出,除了惊人的性能数据,另一个惊喜,是让大模型厂商看到了变现的路径。

RAO给出了这样一种商业逻辑,他认为Databricks 专注于帮助企业构建、训练和扩展满足其特定需求的模型是有意义的,“我们关心企业的采用情况,因为那是我们的商业模式。当客户想要构建、定制和提供服务模型时,我们就会赚钱,”他补充道。

具体到DBRX,我们一探挣钱之道。

作为 LLM 发布的一部分,Databricks 以开放许可证的形式发布了两个模型,但有一些限制:DBRX Base,一个预训练的基础模型,以及 DBRX Instruct,一个针对少量交互的微调版本。

首先,正如上述介绍的,通过Azure数据库在AWS、Google Cloud和Microsoft Azure上支持DBRX,因此企业可以下载该模型,并在任何他们想要的地方在图形处理器(GPU)上运行它。

然后重点来了,企业也可以选择订阅DBRX和其他工具,如检索增强生成(RAG),用于通过Databricks的Mosaic AI Model服务产品定制LLM。(Mosaic AI Model 服务将通过Foundation Model APIs 与 DBRX 连接,这使得企业能够从服务端点访问和查询 LLMs。)

Foundation Model APIs 提供两种定价模式——按Tokens付费和分配的吞吐量。按Tokens付费的定价是基于并发请求,而吞吐量则是按每小时每个 GPU 实例计费。两种费率,包括云实例成本,均从每个Databricks单位 $0.070 开始。

此外,Databriks还为不同的 GPU 配置提供了相应的定价区间。

五、写在最后:开源才刚刚开始

有了稳健的商业模式,开源大模型就有了持续壮大的筹码。重要的是,这也为企业提供了入场AIGC的门票,不仅可以降低使用自身企业数据开发生成性AI用例的成本,而且不会受到封闭模型提供商(如OpenAI)对商业用途的限制。

Rao 认为,这个模型预示着风向的转变,并感觉到开源模型最终会超越像 GPT-4 这样的闭源模型,这与 Linux 超越专有 Unix 系统的历程相似。

“开源才刚刚开始。五年后,世界将会变得有些不同。”

最后的最后,告诉大家,DBRX可以从GitHub网站和Hugging Face 免费下载,用于研究或商业用途——

https://github.com/databricks/dbrx

https://huggingface.co/databricks/dbrx-base

参考链接:

https://www.databricks.com/blog/introducing-dbrx-new-state-art-open-llm

https://analyticsindiamag.com/databricks-creates-history-with-gpt-4-level-open-source-model/