快3倍!Meta 违背经典模型结构,一次预测多个token,路径可行,大模型大幅提速指日可待!

编译 | 伊风

出品 | 51CTO技术栈(微信号:blog51cto)

众所周知,LLMs的工作原理是对下一个token进行预测。

读者朋友们有没有曾这样想过:如果LLM一次预测n个token呢?那是不是就快n倍?Meta也是这样想的!并且付诸实践。

在最近的一项研究中,Meta、以及巴黎高科桥路学院和巴黎-萨克雷大学的研究人员建议,通过让人工智能大型语言模型(LLMs)同时预测多个token,来提高大模型的准确性和速度。

这个大胆的设想,跳出了自回归语言模型的经典结构——一次仅仅预测一个token。

在某些领域,这一方法呈现了显著的优势,速度提高了三倍,生成任务的性能也更好!

虽然多标记预测并不一定成为每种模型和语言任务的通用解决方案,且该方法还存在很大的改进空间。但Meta的研究验证了该思路的可行性,这项技术可能让某些LLM应用大幅进化,例如时下热议的AI编程。

1.只预测下一个token的局限性

训练LLMs的经典方法是所谓的“下一个token预测”,这是一种自监督学习技术,模型被给予一系列token,并预测下一个。

然后大模型会将预测的标记添加到输入中,并重复这个过程,一次一个token。通过在大量文本语料库上一遍又一遍地这样做,模型学习到一般模式,使其能够输出连贯的文本段落。

研究人员已经研究并记录了下一个标记预测在获取语言、世界知识和推理能力方面的局限性:例如,仅仅关注一个标记,模型变得对局部模式过于敏感,忽略了需要对更长视野进行推理的预测。在下一个标记预测上训练的模型还需要大量的数据才能达到人类用更少文本就能获得的流畅度。

Meta的新研究正基于这样的假设:“训练语言模型一次预测多个token,可以提高样本效率。”

2.新技术:一次预测多个token

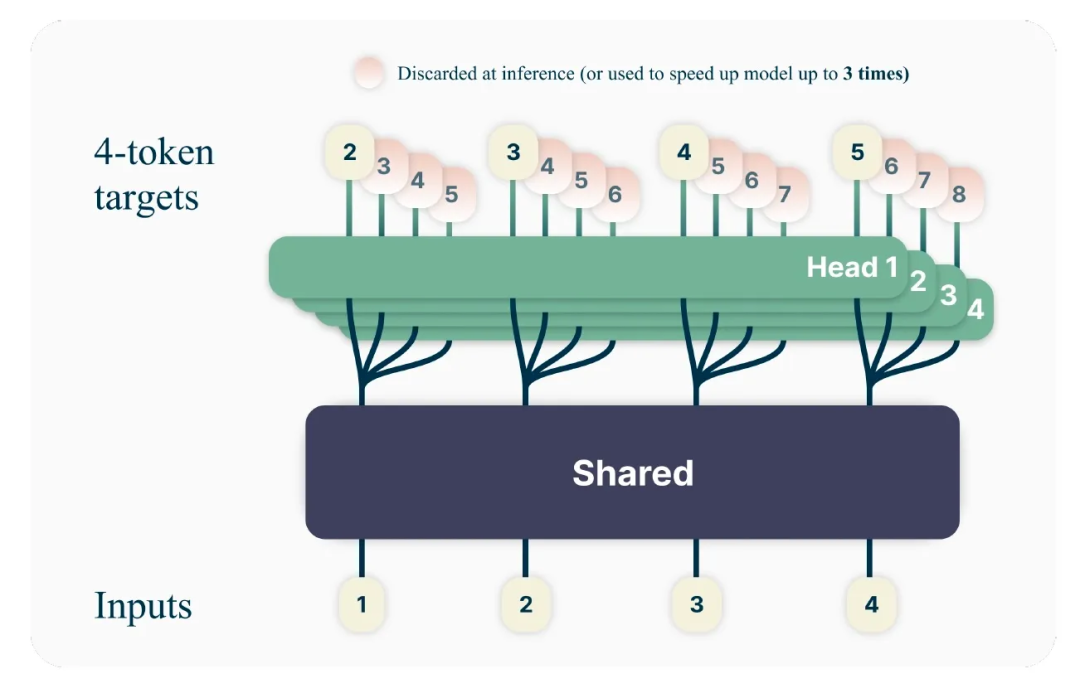

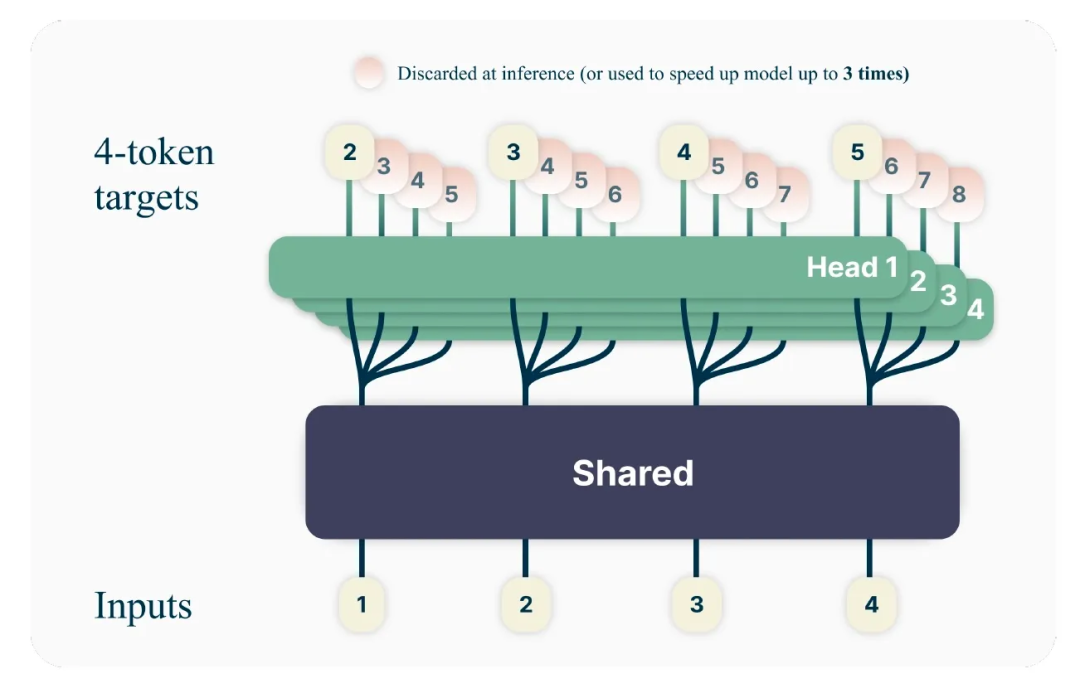

多标记预测指示LLM从训练语料库中的每个位置同时预测多个未来的token。研究人员提出了一个简单的多标记预测架构,不需要额外的训练时间或内存开销。

多标记预测语言模型基于大多数LLMs使用的Transformer架构,尽管有一些修改。模型使用Transformer的主要结构,虽然不再输出单个token,但每个token都有独立的输出头,每个要预测的标记一个。

图片

图片

在推理过程中,模型使用每个预测头去做基本的下一个token预测方案,并使用额外的输出头来加速解码过程。该模型综合利用了该领域中的几项相关的成果。

“在不增加额外成本且保持简单的同时,多标记预测是对训练更强大、更快的Transformer模型的有效调整,”研究人员写道。

3.多标记预测技术的改进效果

研究人员在300百万到130亿参数的各种任务上测试了新的多标记预测方案。

他们的发现包括几个有趣的观测结果。例如,在较小的模型上,多标记预测会导致更差的结果,但随着模型大小的增加,它变得越来越有用。例如,在训练4个标记预测时,6.7亿和130亿参数的模型在MBPP编码基准测试上比基线单标记预测提高了几个百分点。“在相同的计算预算下,使用多标记预测,可以在固定数据集上从大型语言模型中挤出更多的性能,”研究人员写道。

根据研究人员的说法,多标记预测还使模型在跨广泛批量大小的推理时间上快了多达三倍。“使用多标记预测进行预训练,额外的头部(Head)比简单的下一个标记预测模型的微调更准确,我们让模型可以释放自我推测解码的全部潜力,”研究人员写道。

该研究还表明,多标记预测促进了学习长期模式,特别是在模型被训练在“字节级标记化”(byte-level tokenization)上的实验中,其中每个字节都被视为一个单独的标记。在这些实验中,多字节预测以很大的优势超过了基线单字节预测模型。

这对于没有预定义词汇表并且模型必须学习使用非常小的信息块的应用尤其重要。

多标记预测仍有改进空间。例如,要预测的标记的最优数量取决于任务类型和模型大小。科学家们正在考虑多个未来的研究方向,包括自动选择要预测的标记的最优数量的技术,以及研究词汇表大小和多标记预测之间的动态。

这项研究及其未来的迭代可能对企业应用有用,因为它们有潜力为生成任务(如代码完成)提供更快的推理和更高的准确性,而几乎没有或没有额外的成本。由于它还保留了大部分LLM架构,因此可以与Transformer块的其他优化技术兼容,具备很强的迭代潜力。

参考链接:https://venturebeat.com/ai/metas-new-multi-token-prediction-makes-ai-models-up-to-3x-faster/