Llama3大模型本地部署教程,Ollama加open webui可视化页面使用

熊友们,Llama3大模型开源发布了一个月左右,很多熊友反馈让我做一个集成Llama3大模型的整合包放到aistarter上,这!没问题的~但肯定需要排期了,毕竟熊友们在许愿池许下的愿望太多了,我先做个教程吧,教大家本地怎么手动部署大模型吧。方法有很多,这里我仅推荐我认为不错且不错的方法,这里给大家列一下这个视频内容的整体框架吧:

1、 下载地址和方法

2、 安装方法(其实都大同小异,下载双击安装搞定,其中Ollama+open webui是我最喜欢的)

3、 模型存放路径修改

4、 不安装直接体验

5、 aistarter市场,越多人想要的项目咱就尽量排在前面,视频评论就是许愿池,求整合包的单个评论大于1000个赞的就不排期了,直接先安排整合打包。

一、好了,要安装首先是得知道在哪里下载,我附上地址下载应该都会吧,每一款工具也是可以直接一键下载大模型的。最后,咱把视频所说的工具和模型都放到了网盘,通过网盘下载也是OK的。

模型下载:

Llama 3 官网链接:https://llama.meta.com/llama3

模型下载链接:https://llama.meta.com/llama-downloads/

Hugging Face 链接:https://huggingface.co/meta-llama

Replicate 链接:https://replicate.com/meta

GitHub 项目地址:https://github.com/meta-llama/llama3

工具下载:

GPT4All:适合低配置用户,可以在CPU/GPU上运行。

下载地址:https://gpt4all.io/

LMstudio:支持下载多个模型,包括8B和70B等,提供更多模型选择!

下载地址:https://lmstudio.ai/

Jan:https://jan.ai/

Ollama:支持多平台!

下载地址:https://ollama.com/

open-webui:https://github.com/open-webui/open-webui

Docker:https://www.docker.com/products/docker-desktop/

我电脑是win平台的,视频教程所使用的模型和工具我就打包放网盘了,需要的也可以直接下载。

网盘下载:https://pan.quark.cn/s/16c588e48877

二、安装方法真的很多,最简单的一定是后面我整合到aistarter市场里面的,一键下载安装就可以了。

但目前时间精力有限,给熊友们介绍四种方法吧,熊哥外貌控,仅喜欢Ollama+open webui方式去使用的,和ChatGPT不能说毫不相干简直一模一样,毕竟用户习惯摆在那里,前面几个工具熊哥也简单的介绍一下,好了,我们开始:

GPT4All

双击安装,在线下载模型、使用。

LMstudio

双击安装,在线下载模型、使用。(这个模型比较多,有很多用户量化后分享的)

Jan

双击安装,在线下载模型、使用。

对吧,所有工具痛点主要是网络环境问题,这个只能自己想办法解决哈。详细的安装步骤可以看视频

好了,最后一款工具:Ollama+open webui,熊哥推荐的应该不会差,我都是自己亲自测试体验后才给大家录视频的,所以你懂的!!点赞!关注!转发分享一下吧,主动点嘛~~哈哈感谢支持啦,我们开始

(1)下载

1、 下载Ollama

2、 下载open webui

3、 下载Docker

(2)安装

1、安装Ollama

2、并在 Windows 上打开 WSL 功能:

4、 安装Docker

5、 Ollama和Docker设置路径,这个非必要。

6、 安装本地open webui

(1)在CPU下运行:

docker run -d -p 3000:8080 –add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data –name open-webui –restart always ghcr.io/open-webui/open-webui:main

(2)支持GPU运行:

docker run -d -p 3000:8080 –gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data –name open-webui –restart always ghcr.io/open-webui/open-webui:ollama

(4)安装完成通过本地地址:http://127.0.0.1:3000 进行访问

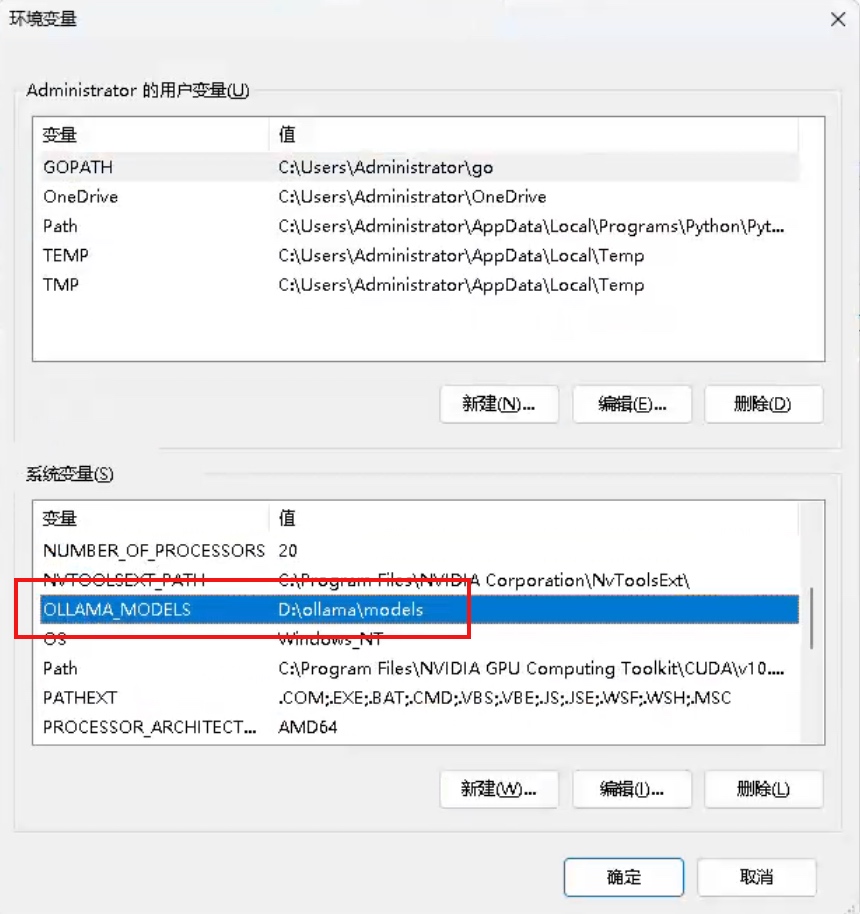

三、模型存放路径修改

1、前三款工具分别在设置里面就可以设置啦,我猜到部分熊友应该不懂英文,又迷茫了,其实!熊哥也很水的,最简单的办法就是打开微信Ctrl+A翻译成中文,这个时候你就是王者,哪里需要看教程。

2、Ollama默认安装路径在C盘,右键打开安装路径,剪切到你想存放的盘符,然后设置环境变量,主要是模型太大,C盘正常不够用。

默认情况下,ollama模型的存储目录如下:

· macOS: ~/.ollama/models

· Linux: /usr/share/ollama/.ollama/models

· Windows: C:Users

如果需要使用不同的目录,则需设置环境变量OLLAMA_MODELS, 把它设置为所选目录。

https://github.com/ollama/ollama/blob/main/docs/faq.md

四、免费安装在线体验地址

NVIDIA Build:https://build.nvidia.com/explore/discover

Groq Playground:https://console.groq.com/playground

Perplexity AI:https://www.perplexity.ai/

Llama Family:https://llama.family/model

Tavily:https://app.tavily.com/home

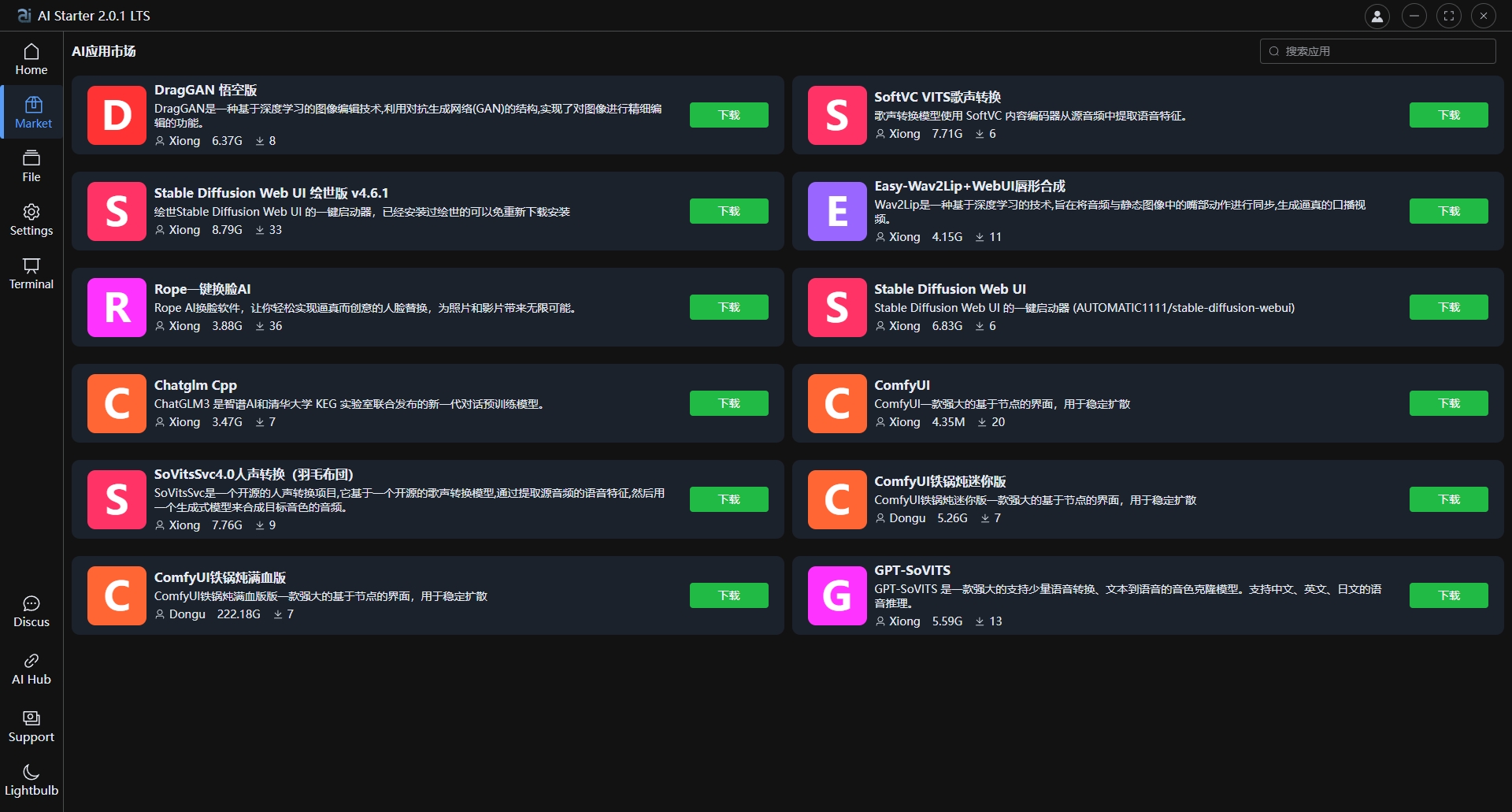

五、重复一下,aistarter是我开发的ai项目管理平台,免费、简单易用!接着目前已经有上万的熊友在使用了,如果出现问题可以翻翻我其他的视频,出现问题大概率是你电脑系统问题或者设置的问题,不然上万的熊友不能使用早骂惨我了哈!!!关于aistarter市场,越多人想要的项目咱就尽量排在前面,视频评论就是许愿池,求整合包的单个评论大于1000个赞的就不排期了,直接先安排整合打包。好了,再见!我们下个视频再见。